Il gruppo di ricerca dell’Ateneo catanese studia algoritmi di visione artificiale per supportare l’uomo nei luoghi in cui vive e lavora prevedendo possibili rischi prima che si verifichi un evento

Un gruppo di ricercatori del Dipartimento di Matematica e Informatica dell’Università di Catania, guidati dal prof. Giovanni Maria Farinella, insieme ad altri gruppi di ricerca di Atenei sparsi in tutto il mondo tra cui anche Facebook AI Research (FAIR), sta portando avanti il progetto Egocentric 4D Live Perception (Ego4D) che prevede la costruzione di un vasto dataset di video che raccoglie scenari della vita di tutti i giorni.

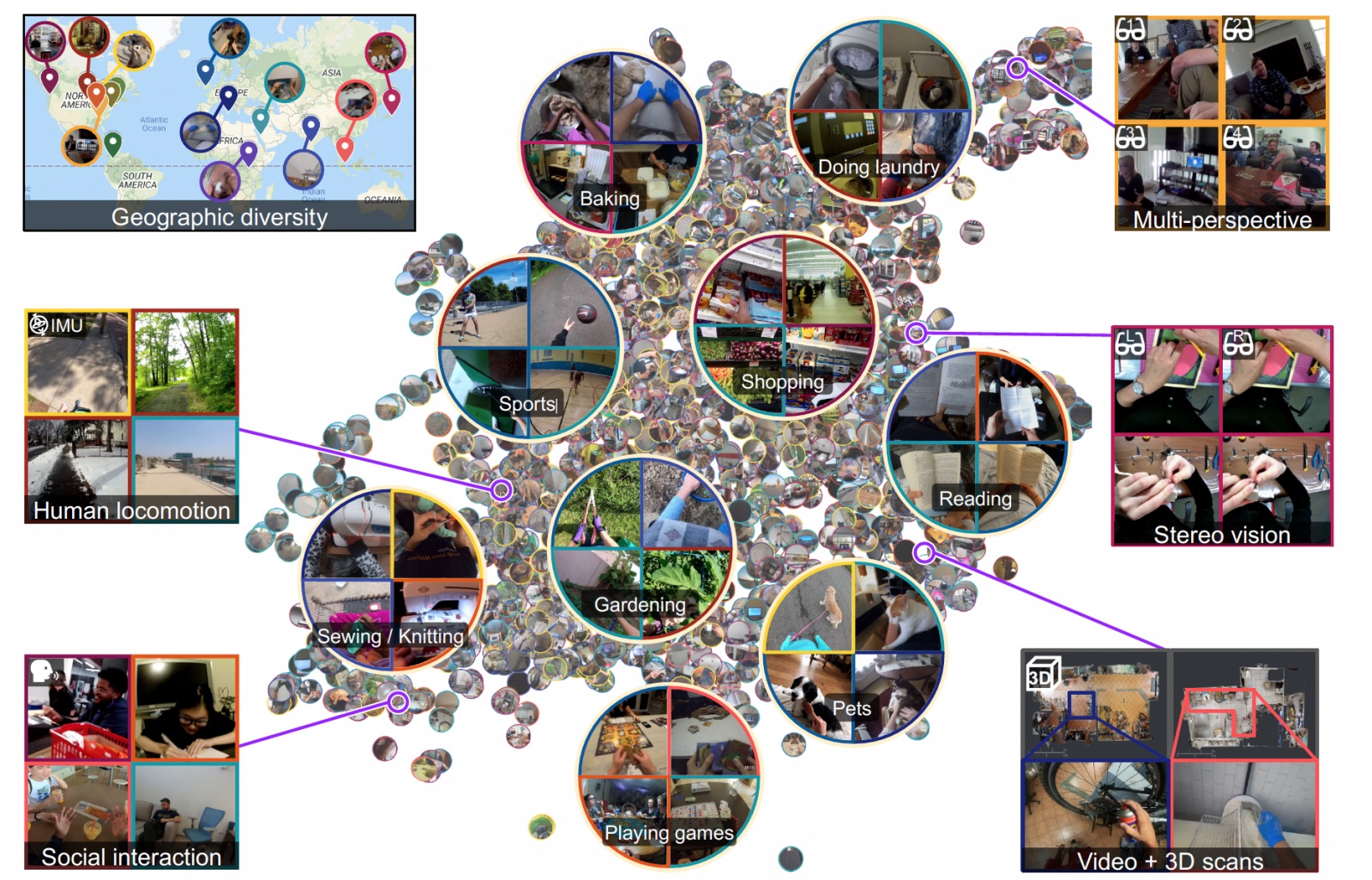

A partire da questi dati, inoltre, il progetto Ego4D si pone l’obiettivo di definire cinque “benchmark”, ovvero un insieme di test atti a verificare la capacità delle macchine di ricordare il passato (memoria episodica), predire il futuro e comprendere – nello stesso momento in cui accadono – le interazioni tra mani e oggetti, le interazioni sociali e le relazioni tra l’audio e la percezione visiva.

Come è facile immaginare, queste applicazioni possono risolvere diverse problematiche aperte, con particolare riferimento all’ambito industriale e alla sicurezza sul lavoro. Pensiamo ad un macchinario robotizzato in grado di prevedere l’azione successiva che compirà l’operaio e quindi di interrompere il proprio funzionamento nel caso in cui la persona che sta lavorando corra il rischio di un infortunio compiendo una azione pericolosa.

I dati raccolti in Ego4D sono acquisiti dal punto di visita umano mediante videocamere indossabili (ovvero in soggettiva o da un punto di vista “Egocentrico”) con lo scopo di addestrare le tecnologie di intelligenza artificiale del prossimo futuro per supportare le persone nello svolgimento del proprio lavoro e nella vita di tutti i giorni. Finora, infatti, questi si sono basati su immagini catturate da una prospettiva esterna all’azione (es. telecamere fisse nell’ambiente quali quelle di sorveglianza). Con Ego4D, invece, un insieme di volontari ha partecipato alla ricerca acquisendo i video con dispositivi indossabili (es. GoPro posizionate sulla testa). Basandosi su questi video, i sistemi di Computer Vision e Intelligenza Artificiale vengono calati all’interno dell’azione, osservano le stesse cose che l’occhio umano percepisce, insieme al contesto reale in cui gli individui operano, alle interazioni che avvengono sia con gli oggetti che a livello interpersonale.

I cinque benchmark individuati e oggetto di studio da parte dei ricercatori, possono avere un impatto significativo per la costruzione di macchine e sistemi di Intelligenza Artificiale capaci di rispondere alle seguenti domande: Cosa è accaduto e quando? Lo scopo è quello di supportare la memoria episodica e assisterci, per esempio, nel ricordare dove abbiamo lasciato il giocattolo preferito di nostro figlio o le chiavi della macchina; Cosa devo fare dopo? L’obiettivo in questo caso è quello di fare delle previsioni su dove è probabile che una persona si sposterà, quali oggetti toccherà, o quale attività eseguirà successivamente.

I futuri sistemi di Intelligenza Artificiale potrebbero evitare, ad esempio, che il lavoratore di una falegnameria subisca un incidente avvicinando troppo le mani alla lama di una sega da banco perché saranno in grado di bloccare automaticamente il movimento del macchinario prima che l’evento si verifichi; Cosa sto facendo e come? Comprendere come le persone interagiscono con gli oggetti cambiandone lo stato, ad esempio quando tagliamo un ortaggio per cucinare o quando lavoriamo a maglia; Chi ha detto cosa e quando? Il riconoscimento audiovisuale può essere utile, ad esempio, per richiamare parti di una lezione o sessione di formazione che abbiamo seguito in maniera distratta; Come stiamo interagendo? Capire le interazioni sociali è fondamentale per migliorare e personalizzare le esperienze delle persone: in tal modo un sistema di Intelligenza Artificiale potrebbe ricordarci con chi abbiamo parlato durante una festa o in un congresso al quale abbiamo preso parte.

Ego4D si propone alla comunità scientifica con oltre 3.000 ore di video - che saranno resi pubblici a partire dal mese di novembre – costituendo così un dataset che, in termini di ore di ripresa, è 20 volte più grande di qualsiasi altro insieme di dati esistente nell’ambito di ricerca in cui il progetto opera.

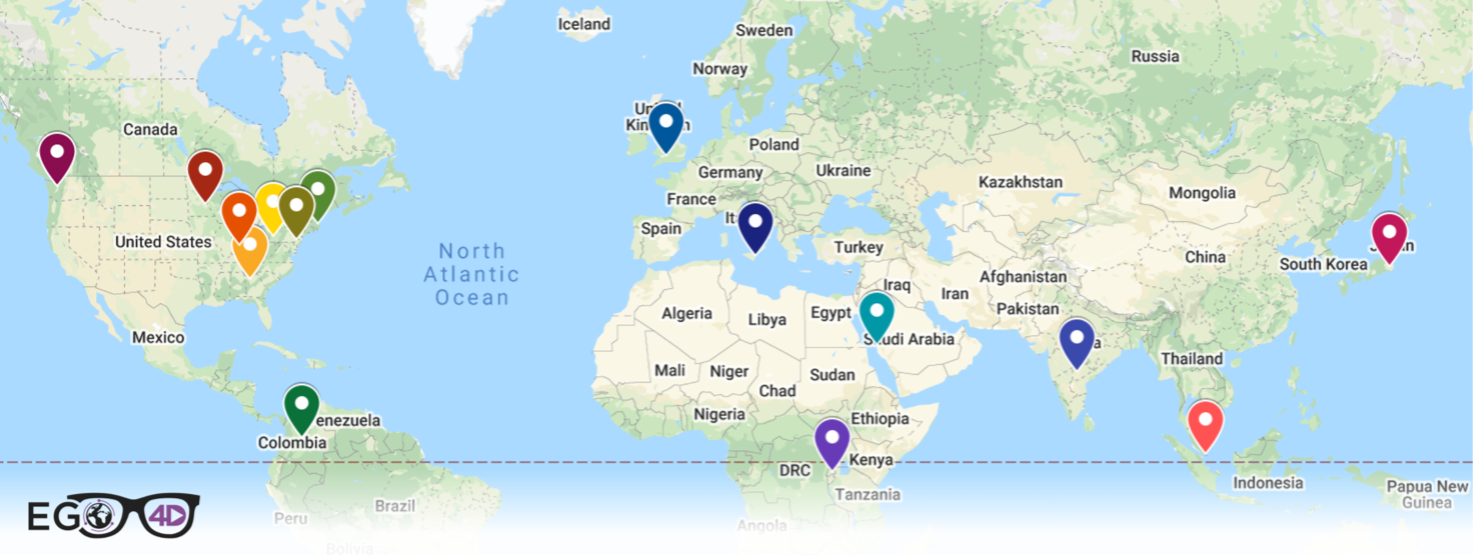

I video sono stati realizzati da più di 850 partecipanti distribuiti in nove diversi paesi, tra i quali Regno Unito, Stati Uniti, Italia, Giappone, India e Ruanda ed estremamente eterogenei tra loro per età, dati demografici, professione e genere. I dati sono stati acquisiti nel rispetto della privacy dei partecipanti allo studio e degli eventuali soggetti terzi.

Gli scenari ripresi sono centinaia, appartengono a contesti della vita di tutti i giorni (cucinare, cucire, fare shopping, disegnare, riparare degli oggetti) e a professioni quali metalmeccanici, falegnami, restauratori, meccanici di scooter e bici, panettieri, elettricisti, muratori.

La diversità di luoghi, persone e attività presenti nei video, rafforza l’importanza dei dati raccolti nell’ambito di questa ricerca dato che la visione egocentrica cambia profondamente a seconda del contesto culturale e geografico di appartenenza. Se in futuro volessimo chiedere ad un assistente di Intelligenza Artificiale di guidarci nella preparazione di una ricetta, questo dovrebbe idealmente essere capace di riconoscere che le modalità di cucinare lo stesso piatto sono influenzate dalla cultura di appartenenza e cambiano quindi da paese a paese.

Insieme ai dati, Ego4D fornirà i risultati sperimentali ottenuti dai ricercatori mediante l’utilizzo di algoritmi di base (baselines) sui cinque benchmark individuati dal progetto.

Il campo di applicazione in cui i ricercatori del Dipartimento di Matematica e Informatica di Catania stanno portando avanti la propria attività all’interno del progetto Ego 4D è quello di supportare gli individui nei luoghi in cui vivono e lavorano: per questo il principale benchmark oggetto di studio presso UNICT è il Forecasting Benchmark, che si concentra sul prevedere le azioni future e le interazioni con l’ambiente degli individui.

Fa parte del gruppo dell’Università di Catania il dr. Antonino Furnari il quale, insieme al prof. Farinella, si è occupato della definizione dei task di predizione del futuro, con particolare attenzione nei confronti delle interazioni che avvengono tra le persone e gli oggetti presenti nella scena.

«Il progetto Ego4D permette ai ricercatori in Intelligenza Artificiale di confrontarsi con nuovi problemi computazionali e studiare algoritmi che possano migliorare lo stato dell’arte e produrre conoscenza utile ad innovare la società in cui viviamo e lavoriamo» spiega il dott. Furnari.

Il prof. Giovanni Maria Farinella, responsabile scientifico del progetto per Unict, spiega che «Ego4D favorirà lo sviluppo di nuovi algoritmi di Intelligenza Artificiale applicabili in ambito industriale». «Questi dovranno essere capaci di predire la prossima azione che sarà svolta da un operatore, ad esempio per diminuire i rischi di incidenti e ottimizzare la formazione dei neoassunti abbassandone i costi, ma anche e soprattutto saranno utili a supportare l’uomo nel corretto svolgimento di un lavoro complesso suggerendo e verificando il prossimo passo da compiere in una procedura» aggiunge.

I progressi nell’ambito della percezione egocentrica, che potranno essere fatti a partire dal progetto Ego4D, forniranno una serie di basi sulle quali sviluppare delle migliori capacità cognitive di cui dotare gli assistenti basati sull’Intelligenza Artificiale che interagiscono con le persone per aiutarle negli ambienti di vita quotidiana.

I membri del progetto fanno capo ai seguenti enti di ricerca: University of Catania (Italia), Massachusetts Institute of Technology, Carnegie Mellon University - Pittsburgh, Georgia Institute of Technology, University of Minnesota, Indiana University Bloomington e University of Pennsylvania (Stati Uniti), University of Bristol (Regno Unito), Carnegie Mellon University Africa (Ruanda), King Abdullah University of Science and Technology (Arabia Saudita), National University of Singapore (Singapore), University of Los Andes (Colombia), University of Tokyo (Giappone), International Institute of Information Technology - Hyderabad (India), Facebook AI Research (FAIR).

I dati raccolti e i risultati delle ricerche effettuate sui 5 benchmark verranno messi a disposizione degli studiosi gratuitamente e a scopo scientifico sul sito https://ego4d-data.org/

A beneficio della comunità scientifica, lo studio effettuato nel progetto Ego4D è inviato per la pubblicazione in modalità open-access sulla piattaforma Arxiv con titolo “Ego4D: Around the World in 3000 Hours of Egocentric Video”. Il progetto verrà inoltre presentato nel workshop EPIC 2021 della conferenza “International Conference on Computer Vision” il prossimo 17 ottobre.